新書推薦: 《

理解中国经济:在大变局中读懂新机遇

》 售價:NT$

252.0

《

饥饿与国家:苏丹的饥荒、奴隶制和权力(1883~1956)

》 售價:NT$

386.0

《

管好你的钱:人人都要懂的财富传承(一本书带你了解财富传承的7种方式)

》 售價:NT$

381.0

《

新质生产力:中国创新发展的着力点与内在逻辑

》 售價:NT$

442.0

《

“漫画强国科技”系列(全4册)

》 售價:NT$

784.0

《

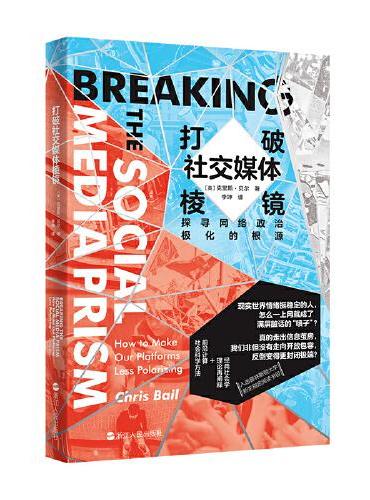

打破社交媒体棱镜:探寻网络政治极化的根源

》 售價:NT$

325.0

《

那一抹嫣红

》 售價:NT$

330.0

《

十八岁出门远行

》 售價:NT$

252.0

編輯推薦:

大多数网络爬虫的开发原理与技巧在专业的公司内部都秘而不宣,至今仍然缺少理论与实践相结合的专门介绍网络爬虫的书籍。本书尝试理论与实践相结合,深入透彻地讲解网络爬虫的原理并且辅以相关代码作为参考。

內容簡介:

本书介绍了网络爬虫开发中的关键问题与Java实现。主要包括从互联网获取信息与提取信息和对Web信息挖掘等内容。本书在介绍基本原理的同时注重辅以具体代码实现来帮助读者加深理解,书中部分代码甚至可以直接使用。

關於作者:

罗刚,计算机软件硕士,毕业于吉林工业大学。2005年创立北京盈智星科技发展有限公司,2008年联合创立上海数聚软件公司。猎兔搜索创始人,当前猎兔搜索在北京、上海以及石家庄均设有研发部。他带领猎兔搜索技术开发团队先后开发出猎兔中文分词系统、猎兔文本挖掘系统,智能垂直搜索系统以及网络信息监测系统等,实现互联网信息的采集、过滤、搜索和实时监测,其开发的搜索软件日用户访问量万次以上。

目錄

第1篇 自己动手抓取数据

內容試閱

第2章 分布式爬虫